画像生成AI「StableDiffusion」で得ておくべき知識を身に付けるのに役立つ「SD Toolset」

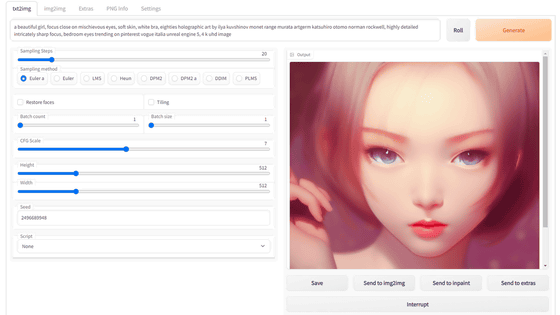

画像生成AI「Stable Diffusion」はモデルデータが一般公開されているため、自宅のPCで誰でも簡単に動かすことができます。しかし、Stable Diffusionを使って自分が望む通りの画像を生成するためにはさまざまな知識が必要になり、初心者は何から学べばいいのかわからなくなりがち。無償で公開されている「SD Toolset」にはStable Diffusionで得ておくべき知識が単元ごとにわけてまとめられているので、ピンポイントで必要な知識を学ぶことができます。

SD Toolset

https://sdtools.org/

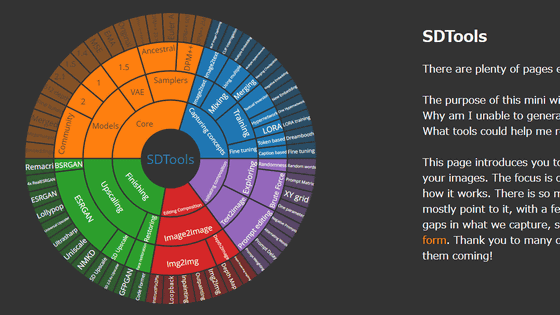

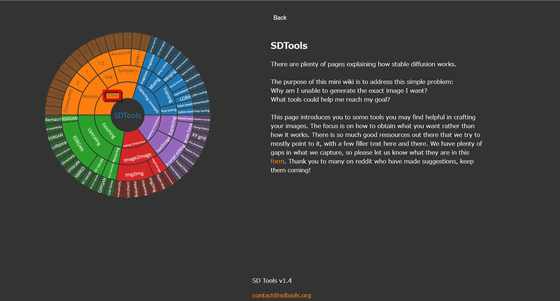

SD Toolsetはこんな感じで、左のカラフルな同心円に単元が視覚的にまとめられており、同心円の内側から気になるカテゴリをクリックしていきます。例えば、Stable Diffusionの根幹部分を知りたい場合は、「Core」をクリック。

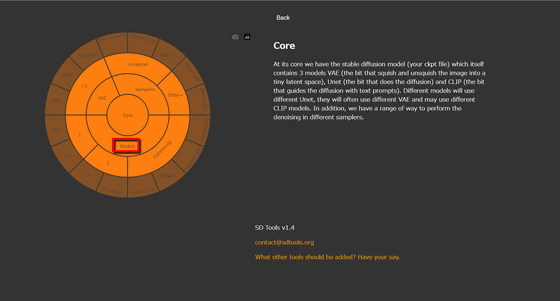

すると、以下のように「Core」だけの同心円に変化します。また、右側には「Core」についての説明が英語で表示されました。モデルデータについて知りたい場合は、「Models」をクリック。

Stable Diffusionのメジャーバージョンは、記事作成時点で2までリリースされています。バージョン2を知りたい場合は「2」をクリック。

「2」の説明は「Stable diffusion 2.0と2.1は、バージョン2.1が改善版としてリリースされたこともあり、大きな違いはありません。どちらもLAION-5B(2Bが20億枚の画像で構成されているのに対して5Bは約50億枚の画像で構成されているという意味)で学習させたものです。しかし、ユーザーから見た最大の変化は、OpenAIのCLIPから、CLIPのオープンソース版であるOpenCLIPに変更されたことでしょう。CLIPの学習内容は公開されていないので、オープンソースの観点から見てこれは素晴らしいことです。しかし、v1では簡単にできたことがv2では難しくなっていることがあり、簡単に移行できないことも多いといわれています」とありました。

「2.1」については「(生成画像のデフォルト解像度が)512×512ピクセルと768×768ピクセルのバージョンがあります。CLIPの代わりにOpenCLIPを使っているため、バージョン1.5までのワークフローをバージョン2.1で再現できないという不満の声も多かったようですが、微調整されたモデルや新しいエンベッディング(埋め込み)が日々登場し、バージョン2.1の機能が拡張され、急速に発展しています」とのこと。

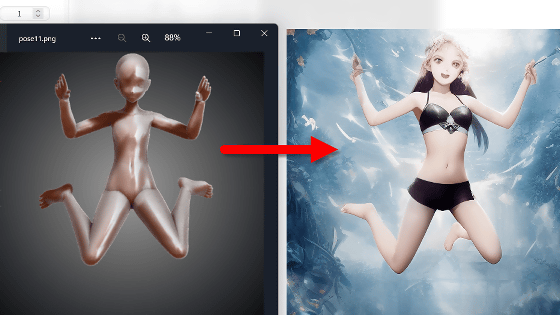

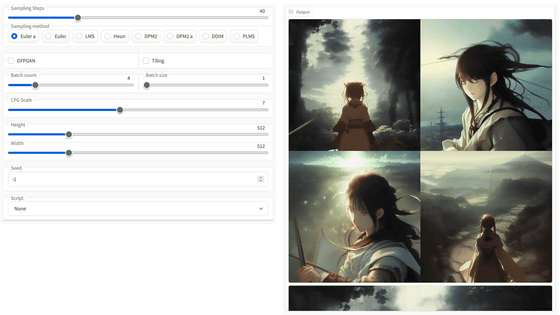

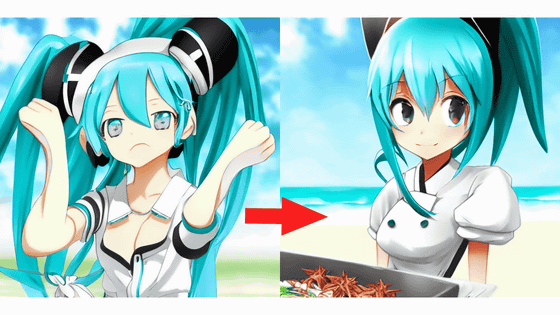

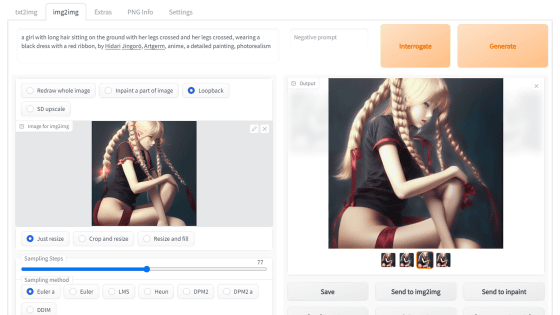

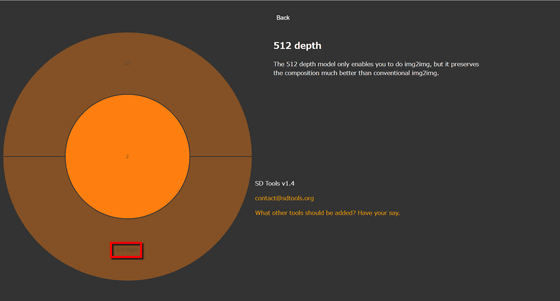

「512depth」は従来のimg2imgよりも高い精度で読み込み画像の構図を保持できる機能。こんな感じで、SD Toolsetを使うことでStable Diffusionを使う上で必要な知識を体系的に学ぶことが可能です。

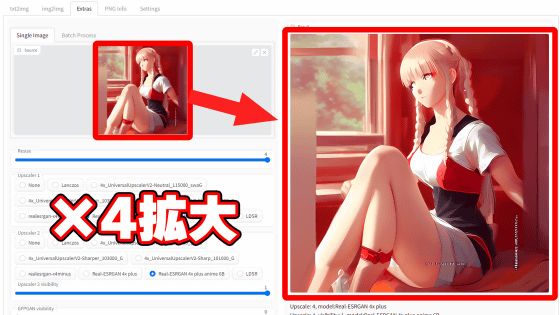

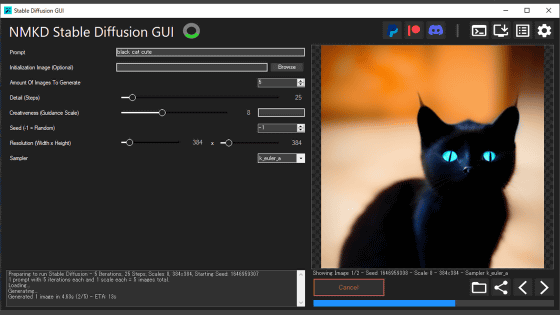

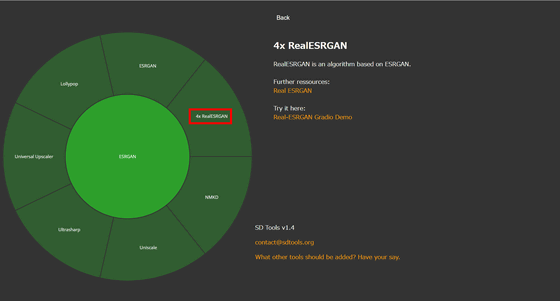

他にも、便利なツールへのリンクが紹介されているケースも。例えば「Finishing」の「Upscaling」から「ESRGAN」で「4x RealESRGAN」を開くと、超解像ライブラリの1つである「4x RealESRGAN」のリンク先が掲載されていました。このようにStable Diffusionで使える便利なツールも知ることができます。

・関連記事

ChatGPTやStable Diffusionを生み出した「機械学習ソフトウェア」の10年間の流れを専門家が解説 - GIGAZINE

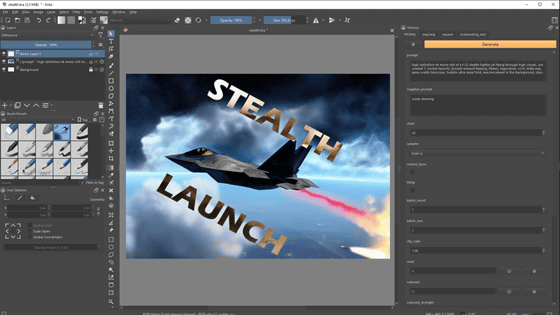

画像生成AI「Stable Diffusion」を4GBのGPUでも動作OK&自分の絵柄を学習させるなどいろいろな機能を簡単にGoogle ColaboやWindowsで動かせる決定版「Stable Diffusion web UI(AUTOMATIC1111版)」インストール方法まとめ - GIGAZINE

ポーズや構図を指定してサクッと好みのイラスト画像を生成しまくれる「ControlNet」&「Stable Diffusion」の合わせ技を試してみたよレビュー - GIGAZINE

Stable Diffusionなどの画像生成AIは「記憶」に基づいて学習した画像をほぼそのまま生成できるという報告 - GIGAZINE

画像生成AI「Stable Diffusion」による画像生成や顔面高解像化などをコマンド一発で実行できる「ImaginAIry」 - GIGAZINE

・関連コンテンツ