Googleが学習していない環境でも「○○を動かして」などの複雑な指示を実行できるロボットAI「RT-2」を発表

Google DeepMindが視覚および言語を行動に変換できる学習モデル「Robotic Transformer 2(RT-2)」を2023年7月28日に発表しました。RT-2を搭載したロボットは「イチゴを正しいボウルに入れて」「机から落ちそうな物を持ち上げて」といった指示を実行できる他、学習データに含まれていない指示も高い精度で実行可能です。

RT-2: New model translates vision and language into action

https://www.deepmind.com/blog/rt-2-new-model-translates-vision-and-language-into-action

What is RT-2? Google DeepMind’s vision-language-action model for robotics

https://blog.google/technology/ai/google-deepmind-rt2-robotics-vla-model/

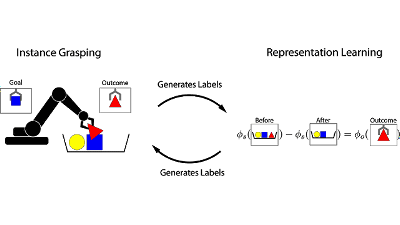

カメラを搭載したロボットに言語で指示を与えられる「vision-language model(視覚言語モデル)」はこれまでにも存在していましたが、既存の学習モデルを用いてロボットに指示を与えるには「画像を識別する学習モデル」「言語を解釈する学習モデル」といった複数の学習モデルを組み合わせる必要がありました。新たに発表されたRT-2は「vision-language-action model(視覚言語行動モデル)」と位置付けられており、単一の学習モデルで「カメラで対象を認識し、言語による指示に沿って行動する」という動作を実行させられます。

RT-2は2022年12月に発表されたRT-1のデータを用いて学習されています。研究チームが6000通り以上の試験を実施した結果、学習済みタスクにおいてRT-2はRT-1と同程度の成功率を記録したとのこと。また、学習していないタスクの成功率はRT-1が32%だったのに対してRT-2は62%にまで向上していました。

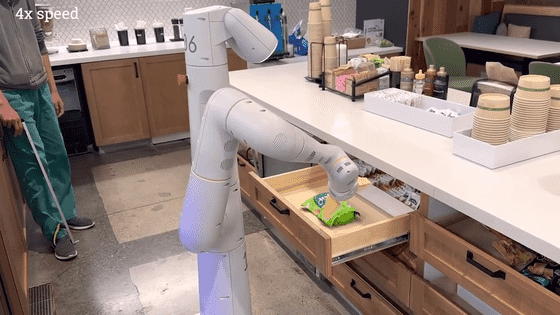

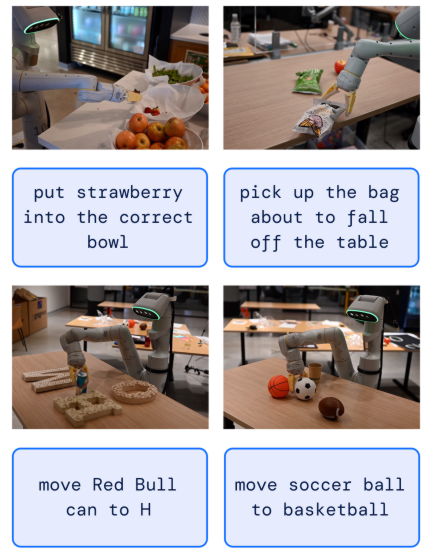

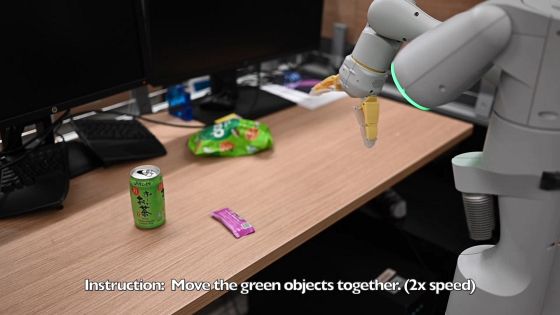

RT-2が実行可能なタスクの例が以下。「イチゴを正しいボウルに置く」「机から落ちそうな入れ物を持ち上げる」「レッドブルの缶を『H』へ移動させる」「サッカーボールをバスケットボールの所へ移動させる」といったタスクを正しく実行できています。

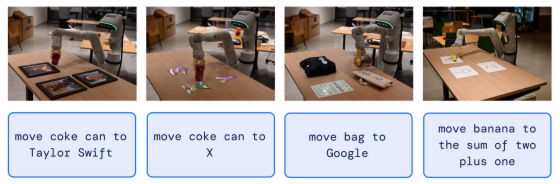

「コーラの缶をテイラー・スウィフトに移動」「コーラの缶を『X』に移動」「バッグを『Google』に移動」「バナナを『1+2』の合計に移動」といった指示も正しく実行できます。

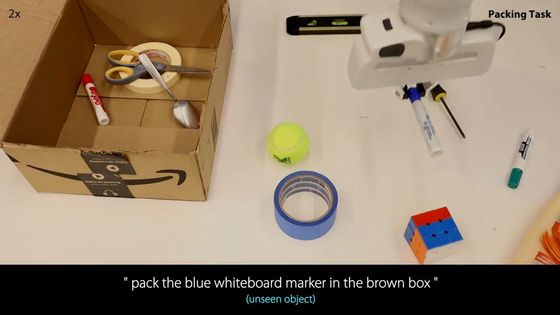

さらに、学習していない物体や背景、環境が対象となった場合でも指示通りの動作が可能とのこと。

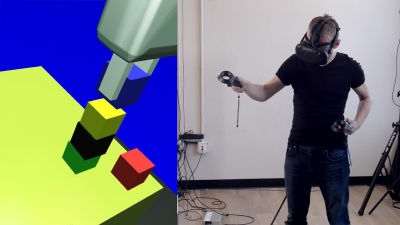

研究チームはRT-2のデモ動画も公開しています。以下の画像をクリックすると「緑色の物を集合させる」といった動作を含む複数の動作をこなすデモ動画を確認できます。

なお、RT-2の研究論文やデモ動画は以下のリンク先で公開されています。

RT-2: Vision-Language-Action Models

https://robotics-transformer2.github.io/

・関連記事

DeepMindが人間レベルにかなり近づいたAI「Gato」を構築、ゲームプレイ・チャット・ロボットアーム操作などが可能 - GIGAZINE

Google DeepMindから「自己改善型AI」が登場、あらゆる場面でのロボットアームの使い方を勝手に身につけることが可能 - GIGAZINE

DeepMindが深層強化学習を利用してアルゴリズムを改善するAI「AlphaDev」を発表、すでにソートアルゴリズムやハッシュ関数の高速化に成功 - GIGAZINE

最強囲碁AIのAlphaGoを開発したDeepMindがGoogleのAI部門と統合して「Google DeepMind」に - GIGAZINE

Google DeepMindのデミス・ハサビスCEOが「GoogleとDeepMindはなぜ統合されたのか」を語る - GIGAZINE

・関連コンテンツ