GoogleがAI特化プロセッサTPUの第5世代モデル「TPU v5e」を発表、前モデル比で1ドル当たりのトレーニングパフォーマンス最大2倍・推論パフォーマンス最大2.5倍

2023年8月30日、Googleが独自に開発する機械学習特化のプロセッサ「Tensor Processing Unit(TPU)」の第5世代モデルとなる「TPU v5e」を発表しました。Googleは大規模言語モデル(LLM)や生成AI(ジェネレーティブAI)といった人気のAIを構築するための「コスト効率とパフォーマンスに優れたプロセッサ」としてTPU v5eをアピールしています。

Announcing Cloud TPU v5e and A3 GPUs in GA | Google Cloud Blog

https://cloud.google.com/blog/products/compute/announcing-cloud-tpu-v5e-and-a3-gpus-in-ga/

Inside a Google Cloud TPU Data Center - YouTube

Google Cloud and NVIDIA Expand Partnership to Advance AI Computing, Software and Services | NVIDIA Newsroom

https://nvidianews.nvidia.com/news/google-cloud-and-nvidia-expand-partnership-to-advance-ai-computing-software-and-services?=&linkId=100000216031272

Google Cloud announces the 5th generation of its custom TPUs | TechCrunch

https://techcrunch.com/2023/08/29/google-cloud-announces-the-5th-generation-of-its-custom-tpus/

Google announces new TPUs, rolls out Nvidia H100 GPUs, as it adds generative AI-focused cloud services - DCD

https://www.datacenterdynamics.com/en/news/google-announces-new-tpus-rolls-out-nvidia-h100-gpus-as-it-adds-generative-ai-focused-cloud-services/

Google Cloud unveils AI-optimised infrastructure enhancements

https://www.cloudcomputing-news.net/news/2023/aug/29/google-cloud-unveils-ai-optimised-infrastructure-enhancements/

Details on Google's AI updates to cloud infrastructure • The Register

https://www.theregister.com/2023/08/29/google_next_ai_updates/

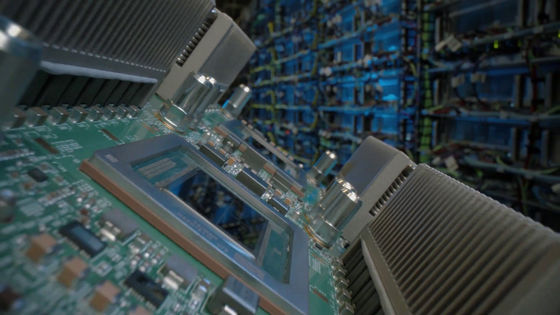

TPU v5eは中規模および大規模なトレーニングと推論に必要なコスト効率とパフォーマンスを両立することを目的に構築された新世代のTPUです。一世代前のモデルとなるTPU v4と比較して、大規模言語モデル(LLM)および生成AIモデルでは1ドル当たり最大2倍のトレーニングパフォーマンスと、1ドル当たり最大2.5倍の推論パフォーマンスを実現可能です。TPU v5eを利用することで、より多くの組織がTPU v4利用時の半分以下のコストで大規模かつ複雑なAIモデルをトレーニング・展開可能となります。

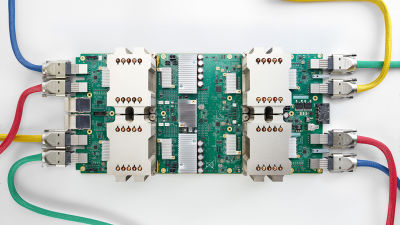

コスト面のメリットを享受するためにパフォーマンスや柔軟性を犠牲にすることはなく、パフォーマンス・柔軟性・効率のバランスが取れており、最大256個のチップを400Tb/s以上の総帯域幅と100PetaOPSで相互接続することが可能です。TPU v5eは非常に多用途で、単一スライス内の1チップから250個以上のチップに至るまで、8つの異なる仮想マシン(VM)構成をサポート。これによりユーザーは幅広いLLMおよび生成AIモデルサイズに対応可能となります。

AssemblyAIでテクノロジー担当ヴァイスプレジデントを務めるドメニック・ドナト氏は、「TPU v5eは当社の実稼働ASRモデルで推論を実行する場合、市場の同等のソリューションと比較して、1ドル当たり最大4倍のパフォーマンスを常に提供してくれました。Google Cloudソフトウェアスタックは本番環境のAIワークロードに最適であり、高度な深層学習モデルの実行専用に構築された TPU v5eハードウェアを最大限に活用できます。このハードウェアとソフトウェアの強力な組み合わせにより、コスト効率の高いAIソリューションを顧客に提供する当社の能力が劇的に加速しました」とコメントしています。

TPU v5eはHugging FaceのTransformersやAccelerate、PyTorch Lightning、Rayなどの人気オープンソースツールに加え、JAX、PyTorch、TensorFlowなどの主要なAIフレームワークの組み込みサポートも提供します。さらに、次期PyTorch/XLA 2.1リリースでPytorchのサポートをさらに強化することもアナウンスされました。このアップデートにはTPU v5eのサポートや、大規模なモデルトレーニングのためのモデルとデータの並列処理などの新機能が含まれます。

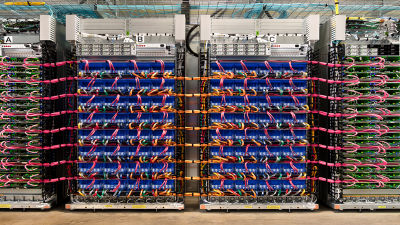

さらに、トレーニングジョブのスケールアップを容易にするため、マルチスライステクノロジーをテスト導入します。これによりユーザーは物理TPUポッドの境界を超えて、AIモデルを最大数万のTPU v5eまたはTPU v4まで簡単にスケールできるようになります。これまで、TPUを使用するトレーニングジョブはTPUの1つのスライスに制限されており、TPU v4の場合は最大スライスサイズが3072チップに制限されており、これに伴い最大ジョブサイズも制限されていました。マルチスライスを使用すると、開発者は単一ポッド内のチップ間相互接続 (ICI)経由、あるいはデータセンターネットワーク(DCN)上の複数のポッドにまたがりワークロードを最大数万チップまで拡張可能となります。このマルチスライス技術は、Googleの最先端のPaLMモデルの作成にも利用されており、Googleは「Google Cloudの顧客にも提供できることを嬉しく思います」と述べました。

Google CloudではNVIDIAと共に幅広いワークロードでAIをより利用しやすくなるように、NVIDIA L4 GPUを搭載したクラウドVM「G2 VM」を提供しています。さらなるハイエンドクラウドVMとして、Google Cloudは「A3 VM」を発表しました。A3 VMはNVIDIA H100 Tensor コア GPUを搭載したモデルで、特に要求の厳しい生成AIワークロードやLLMトレーニングに専用に構築されたVMです。NVIDIA製GPUとGoogle Cloudの最先端インフラストラクチャーテクノロジーを組み合わせることで大規模なスケールとパフォーマンスが提供され、前世代と比較して3倍のトレーニング速度と10倍のネットワーク帯域幅を実現しています。また、A3は大規模運用も可能で、ユーザーはモデルを数万のNVIDIA H100 GPUに拡張することも可能です。

A3 VMは2つの第4世代Intel Xeonスケーラブルプロセッサ、1つのVM当たり8基のNVIDIA H100 GPU、2TBのホストメモリを備えています。最新のNVIDIA HGX H100プラットフォーム上に構築されたA3 VMは、第4世代NVIDIA NVLinkテクノロジーを介して8つのGPU間で3.6TB/sのバイセクション帯域幅を実現。ネットワーク帯域幅の向上は、TitaniumネットワークアダプターとNVIDIA Collective Communications Library(NCCL)の最適化によって実現されます。全体として、A3 VMは最先端のAIモデルの構築を目指すAIイノベーターや企業にとって大きな後押しとなるそうです。

画像生成AI「Midjourney」を提供するMidjourneyの創設者兼CEOであるDavid Holz氏は、「Midjourneyは新しい思考媒体を探求し、人類の想像力を拡張する独立した研究機関です。私たちのプラットフォームは、Google Cloudの最新のG2およびA3を搭載しています。G2ではT4よりも効率が15%向上していましたが、A3はA100よりも2倍も高速に生成が可能となっています。これにより、ユーザーは探索や作成中にフロー状態を維持できるようになります」とコメントしました。

・関連記事

「CPU」「GPU」「NPU」「TPU」の違いを分かりやすく説明するとこうなる - GIGAZINE

機械学習に特化した第4世代プロセッサ「TPU v4」をGoogleが発表、前世代の2倍以上のパフォーマンスに - GIGAZINE

GoogleがAIを用いてAI専用プロセッサの開発を爆速化したことを発表 - GIGAZINE

Googleの機械学習用マシン「Cloud TPU Pod」のパブリックベータ版が提供開始 - GIGAZINE

Googleの機械学習マシン「第2世代TPU」の構造を公開された写真から推測する - GIGAZINE

・関連コンテンツ