新たに「Llama 2 70B」と「Stable Diffusion XL」が追加されたAIベンチマークテスト「MLPerf Inference v4.0」の結果が発表される

ニューラルネットワークのパフォーマンス評価を実施する業界コンソーシアムのMLCommonsは、さまざまなシナリオでハードウェアのAI処理性能を測定できるベンチマークテスト「MLPerf Inference」を設計しています。最新の「MLPerf Inference v4.0」では、パフォーマンス指標として新たにMetaの大規模言語モデル「Llama 2 70B」と画像生成AIの「Stable Diffusion XL」が追加されました。

New MLPerf Inference Benchmark Results Highlight The Rapid Growth of Generative AI Models - MLCommons

https://mlcommons.org/2024/03/mlperf-inference-v4/

Nvidia Tops Llama 2, Stable Diffusion Speed Trials - IEEE Spectrum

https://spectrum.ieee.org/ai-benchmark-mlperf-llama-stablediffusion

NVIDIA Hopper Leaps Ahead in Generative AI at MLPerf | NVIDIA Blog

https://blogs.nvidia.com/blog/tensorrt-llm-inference-mlperf/

MLPerf Inference v4.0: NVIDIA Reigns Supreme, Intel Shows Impressive Performance Gains

https://www.maginative.com/article/mlperf-inference-v4-0-nvidia-reigns-supreme-intel-shows-impressive-generative-ai-performance-gains/

MLCommonsは絶え間なく変化する生成AIの環境に対応するため、ベンチマークテストの「MLPerf Inference v4.0」に新たなモデルを追加するかどうかを検討するタスクフォースを設置したとのこと。モデルのライセンスやデプロイの容易さなどの要因を慎重に検討した結果、新たに「Llama 2 70B」と「Stable Diffusion XL」をベンチマークに含めることが決定されました。

Llama 2 70BはMetaの大規模言語モデルであり、700億個のパラメータを持つ「より大きな」大規模言語モデルの指標として選択されました。Llama 2 70Bは以前のMLPerf Inference v3.1で導入されたGPT-Jよりもパラメータが桁違いに大きく、それに応じて精度が向上しています。Llama 2 70Bはモデルサイズが大きいため、小さな大規模言語モデルとは異なるクラスのハードウェアが必要。このため、パフォーマンス指標にLlama 2 70Bを含めることでハイエンドシステムに適応したベンチマークになるとMLCommonsは説明しています。

一方のStable Diffusion XLは、26億ものパラメータを持つ画像生成AIであり、テキストベースのプロンプトを介して精度の高い画像を生成するために使われます。多くの画像を生成することで、MLPerf Inference v4.0ではレイテンシやスループットなどの指標を計算し、全体的なパフォーマンスをより正確に把握できるとのことです。

MLPerf Inferenceの共同議長であるMiro Hodak氏は、「MLPerf Inference v4.0のリリースは、ベンチマークスイートに生成AIを全面的に採用したことを意味します。ベンチマークの3分の1は生成AIワークロードです。大小の大規模言語モデルや、テキストから画像の生成など、MLPerf Inferenceベンチマークスイートが最先端の分野をカバーすることを保証します」とコメントしました。

MLPerf Inference v4.0にはASUSやDell、富士通、Google、Intel、Lenovo、NVIDIA、Oracle、Qualcommなどを含む23の組織から、8500件を超えるパフォーマンス結果が提出されたとのこと。また、Dell、富士通、NVIDIA、Qualcommの4社が、MLPerf Inference v4.0のデータセンターに焦点を当てた電力数値を提出したと報告されています。

MLPerf Inference v4.0のベンチマークは、世界中のデバイスでの使用を想定した「Edge」システムと、データセンターでの使用を想定した「Datacenter」システムに分かれています。「Edge」と「Datacenter」の結果は、それぞれ以下のページで確認することが可能です。

Benchmark MLPerf Inference: Edge | MLCommons V3.1 Results

https://mlcommons.org/benchmarks/inference-edge/

Benchmark MLPerf Inference: Datacenter | MLCommons V3.1

https://mlcommons.org/benchmarks/inference-datacenter/

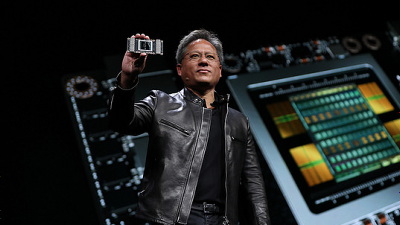

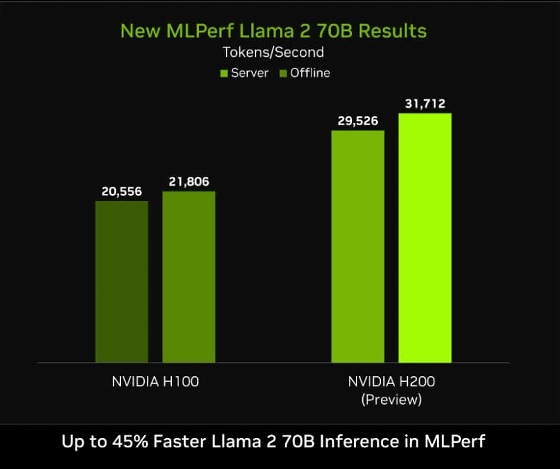

新しい生成AIカテゴリーでトップのパフォーマンスを記録したのは、8個のNVIDIA H200を組み合わせたNVIDIAのシステムでした。H200システムは、Llama 2 70Bで最大3万1000トークン/秒を達成し、Stable Diffusion XLでは13.8クエリ/秒を達成しました。

MLPerf Inference v4.0のLlama 2 70Bベンチマーク結果をH100とH200で比較したグラフが以下。H200が最大45%優れたパフォーマンスを発揮することがわかります。MLPerf Inferenceを使えば、こんな感じに異なるハードウェアのAI処理性能を分かりやすく比較できるというわけです。

・関連記事

60以上の大規模言語モデルに19種類の質問を行うベンチマークテストの結果公開 - GIGAZINE

Metaが商用可能な大規模言語モデル「Llama 2」を無料公開、MicrosoftやQualcommと協力してスマホやPCへの最適化も - GIGAZINE

従来のStable Diffusionより大幅に強化された画像生成AI「Stable Diffusion XL」のベータ版がテスト公開されたので使ってみた - GIGAZINE

Stability AIが高性能画像生成モデル「SDXL 1.0」をリリース&すぐに使えるウェブアプリも公開されたので使ってみた - GIGAZINE

Stable Diffusion XLがプロンプト入力に追従して爆速画像生成してくれる「SDXL Lightning」のデモが公開中 - GIGAZINE

Appleが複数のAIベンチマークで最先端のパフォーマンスを実現できるマルチモーダルAIの構築手法を発表、AIとApple製品にとって大きな進歩となる可能性 - GIGAZINE

GPT-4の半分以下の計算でほぼ同等なIQを持つパーソナルAI「Pi」と基盤モデル「Inflection-2.5」が登場 - GIGAZINE

GoogleのチャットボットAI「Bard」がついにベンチマークスコアでGPT-4を上回って第2位に浮上 - GIGAZINE

MetaがAI安全ツール「Purple Llama」を発表、オープンな生成AIモデルの安全性を高めるツールや評価システムを提供 - GIGAZINE

・関連コンテンツ