コロナ禍をきっかけに広がったバーチャルライブですが、最近ではその進化のスピードが以前に増して加速しています。

ソニー・ミュージックレーベルズは今年3月、独自に制作した仮想空間を舞台に、さまざまなアーティストのライブを楽しむことができるショートライブプロジェクト「ReVers3:x(リバースクロス)」を始動。その第1弾XRライブでは、人気ラッパーのKEIJUが仮想空間上の東京のストリートに設置されたステージに登場し、ライブを披露しました。

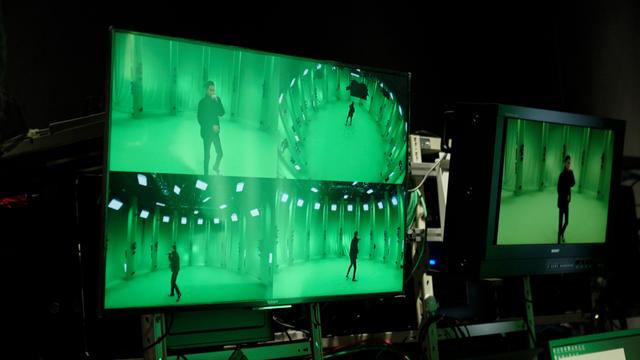

このライブは、世界最高品質のソニーのボリュメトリック撮影スタジオ「Volumetric Capture Studio Tokyo」にて撮影。撮影時にはスタジオを取り囲む数十台のカメラで撮影した実在の人物や場所を3次元のデジタルデータに変換し、任意の方向から見た3D映像として高画質に再現できる“ボリュメトリックキャプチャ技術”が活用されています。

また、ソニーのカメラによる4K撮影に加え、ゲーム制作などで使われる3D制作プラットフォーム「Unreal Engine」を活用した仮想空間の中で行なわれた、VJチームによる高精細な照明などのVJ演出にも注目が集まりました。

そんなソニーの最新技術を活用したグループ横断の取り組みとなる「ReVers3:x」。始動の背景やそこで活用されたテクノロジーがXRライブに与えた影響などについて、プロジェクトの総指揮を務めたソニー・ミュージックレーベルズの齋藤亮太さん、Volumetric Capture Studio Tokyoでの撮影を指揮したソニーグループの林亮輔さん、VJチーム・REZのKAZOE NOBUAKIさん、空間演出ユニット・huezのayafujiさんにお聞きしました。

齋藤亮太(株式会社ソニー・ミュージックレーベルズ 第2レーベルグループ キューンミュージック第一制作部 )

#1に登場したKEIJUのA&R・マネジメント、ReVers3:xのプロジェクト全体のプロデュースと企画を担当。

林亮輔(ソニーグループ株式会社 R&Dセンター 事業探索・技術戦略部門)

シネマ/放送番組制作向けカメラやシステムの商品企画を担当後、2017年からXRコーポレートプロジェクトに参画。『Hikaru Utada Laughter in the Dark Tour 2018 “光“&”誓い“ VR』『いきものがかり Volumetric Live ~生きる~』などのXR作品制作に携わる。

KAZOE NOBUAKI(REZ& / VJ / ビジュアルアーティスト)

ライブイベントや音楽フェスティバルの視覚演出を行う。2020年より「Moment Tokyo x REZ& x huez」としてUNREAL ENGINEを使用したバーチャルライブを制作・開発。VJのコミュニティー『VJ概論』主催。

ayafuji(huez / ビジュアルアーティスト)

ライブや展示空間を総合的に演出する空間演出チーム「huez」に所属。主にXR領域で、開発のマネジメント・計算リソースの管理、セクション同士の連携や技術的なニーズの発見・ヒアリングを通して、テクニカルな視点から質を整える立場で携わっている。

──「ReVers3:x」がプロジェクトとして始まったきっかけを教えてください。

齋藤:ソニー・ミュージックレーベルズ内で私が所属しているレーベルに、今回出演したKEIJUをはじめ、ヒップホップカルチャーに沿ったアーティストが何組かいて。そこでストリーミング戦略の一環として、プロモーションのためにXRライブを提案したのがきっかけです。

このプロジェクトの制作チームであるMoment Tokyo、REZ、huezは、この企画の以前からXRライブを制作していて、それを拝見したことがきっかけで、コロナが収束した後もリアルライブのみに戻るのではなく、配信ライブ独自の表現と共存していくなと思ったこともあり、今回はその可能性を探る意味もありました。そこから制作チームと話していく中で、以前いきものがかりの配信ライブで使用したボリュメトリックキャプチャ技術を使えないかというアイデアが出て、ソニーの林さんのチームに相談したところ、ぜひというお応えを頂き、ご協力頂く形でプロジェクトが始まりました。

──近未来を思わせる仮想の東京が舞台となりましたが、この世界観はどのようにして生まれたのでしょうか?

齋藤:海外では、有名なラッパーが『フォートナイト』でバーチャルライブをやったり、eスポーツチームを持っていたりなど、ゲームが「クールなもの」としてヒップホップやストリートカルチャーと強く結びついています。

一方日本のヒップホップシーンでは、普段からゲームに親しんでいるミュージシャンやラッパーたちも、公にはあまりそのことを口にしていませんし、日本のeスポーツコミュニティにヒップホップを聴いている人は多いのに、それもまだあまり表面化されているとは言えません。

そこ を結びつけ、横断するようなイメージで、 “東京をモチーフにしたサイバーパンク的な世界観”を作ることを考えました。

KAZOE:XRライブでは、空間をはじめにどう定義するかが大切になります。今回の空間定義は「50年後のメタバース空間上の東京の街をジャックして、2022年のアーティストがライブする」でした。

今回定義した 50年後の日本は言論統制され、気軽に人が言葉で表現することができないかもしれない。でも、2022年においては、まだラッパーがリリックで自由に自己表現できる。そんな仮想設定から、「現在から未来を変えたい」という意味を込めています。

──Volumetric Capture Studio Tokyoは、どのような目的で運営されているのでしょうか?

林: PlayStation®VR ができて以降、ソニーの中でVRの活用方法を探ることを目的に、グループを横断するVRプロジェクトが立ち上がりました。しばらくは宇多田ヒカルさんのVRコンテンツ制作などに関わってきましたが、近い将来メタバースがやってきた時に、3Dでデータをキャプチャしておかないと視点の変更が難しくなるだろうということでVolumetric Capture Studio Tokyoが設立されました。

現在は、2Dのボリュメトリックキャプチャ技術を提供するほか、将来的に3Dのエンターテインメントが出てくる時代になった時に、どんな価値を顧客に提供できるか、そのための技術に関して、ソニーグループの中のエンタテインメント側の企業と一緒に、実験と開発を行なっています。そのひとつが、ソニー・ミュージックレーベルズとのReVers3:xです。

──ReVers3:xでは、Volumetric Capture Studio Tokyoのどのようなシステムや技術を使ってライブ撮影が行われたのでしょうか?

林:スタジオでは、ボリュメトリックキャプチャ技術を使って1〜5人程度までの人物の動画を3DCG化することができます。そのデータはARで見せることの他にも、2Dコンテンツの特殊カメラワークにも使用可能です。

例えば、通常の4Kカメラを使ったブルーバックでの撮影では、実写映像とCGをリアルタイムで合成することはできても、カメラワーク自体はスタジオの外に出ていくことはできません。そこで、今回はまるでドローンやクレーンを入れて撮影したようなカメラワークや照明などの映像演出ができるように、Moment Tokyoさんにボリュメトリック映像をお渡しして、演出を入れてもらいました。

また、アップで撮影した映像は高品位である必要があったため、2Dのクロマキー撮影による映像も使いながら、カメラワークとして同時に切り替えて合成することにも協力しています。

──KAZOEさんとayafujiさんは具体的にどういったことを行なわれたのでしょうか?

KAZOE:僕は映像制作の総監督として、制作に使うツールの選定から関わっています。今回はカメラなど演出をまとめるのにTouchDesigner、レンダリングにUnreal Engineを使っています。またソニー・ミュージックレーベルズさんとMoment Tokyoチームが考えた概念をライブに落とし込む時に、どんな要素があればXRライブと言えるか、コミュニケーションをどう進めていくかリードしていくなど、ディレクターとしての役割も大きかったですね。

ayafuji:僕はテクニカルディレクターという立場で参加しました。ボリュメトリックキャプチャ技術は、これまで僕らがやってきた中でもかなり新しいものだったので、それを自分たちのプロダクションに合わせていくための作業を担当しています。

──ボリュメトリックキャプチャ技術を活用したReVers3:xと、他のバーチャルライブとの差異は?

KAZOE:今のXRライブの主な課題は、現実空間のアーティストを、いかにしてデジタル空間に連れて行くかということです。

今回のようなXRライブも、実際のユーザーの視聴環境としては、現状YouTubeなどの2Dプラットフォームに依存したのものなので、衣装や髪型を自由にしたいと考えるアーティストがいたとしても、クロマキー撮影で取り込んでしまうと見え方自体は平面的になってしまいます。そうなると、カメラが自由に動かないと空間性を感じられなくなってしまうため、アーティストの身体性が感じられなくなり、普通の配信ライブとの違いが生まれにくくなります。

その意味でボリュメトリックキャプチャ技術は、アーティストをキャプチャーすることでデジタル空間上に連れて行くことができる、この世界とバーチャルを繋ぐゲートの役割を果たす技術だと思っています。

──ボリュメトリックキャプチャ技術によって、XRライブはどう変化するのでしょうか?

KAZOE:今、僕らが日常的に触れているバーチャル空間は動画サイトやSNSを通してのものくらいだから、そこから得られる感覚や体験は、まだまだ未知の部分も多い。だから、別の場所で、バーチャル空間の身体性を強調する必要性があると思っています。

ayafuji:Moment TokyoさんやKAZOEさんとXRライブを作る時は、毎回現実世界から演者をクロマキー撮影で入れるのか、アバターで入れるのかなど、バーチャル空間に連れてくるための“演者システム”をライブのコンセプトに沿って決めています。

今回はそこにボリュメトリックキャプチャ技術が入ることになりましたが、特に身体性にフォーカスして言えば、この技術自体がXRライブにとってはかなり大きなアドバンテージだと思っています。また、この技術では、あらゆる角度から対象を捉えることができるため、アーティストが良く見える角度をあとから決めることができるというのも、制作環境にかなり影響を与えています。クロマキー撮影の場合だと、その瞬間、カメラマンが決めきった画角で撮影しますが、ボリュメトリックキャプチャだと、撮った後のプロセスも可能性に満ちています。

──レンダリングにUnreal Engineを使用した理由を教えてください。

KAZOE:メタバース空間の制作では、UnitiyかUnreal Engineのどちらかのゲームエンジンが使われることがほとんどですが、僕らは、物理空間に即した光や表面の反射具合をCG空間上で再現することができるPBR(物理ベース レンダリング)機能があることから、Unreal Engineを使っています。

PBRによってリアルな光が再現されることで、人はデジタル空間に現実の延長を感じ、親しみを持つことができます。メタバース空間を制作する上で、その部分は特に重要だと考えています。

ayafuji:Unreal EngineでもUnityでも、同じレベルのものを作ることができるんですが、Unreal Engineにはデフォルト機能として照明やカメラのパラメーターを調整する機能があります。それと、アセットストアにレーザーアセットががあるのですが、これは弊社のレーザーアーティストが納得するレベルで本物のレーザーのパラメータが揃っていたりします。

つまり、現実で照明やレーザー、カメラマンとして活動している人に触ってもらう時に、スムースにバーチャルに移行してもらえるんです。その柔軟性の高さも、僕らがUnreal Engineを使う理由のひとつです。

──ReVers3:xにはどんな可能性があるとお考えでしょうか?

林:我々が提供できる技術を一般向けに普及させるには、まだまだ難しい部分があります。でも今回のプロジェクトを通じて、今年中にメタバースの意識づけだけでもできれば、今後はそれがビジネスになっていく可能性も広がります。今回はその第1弾をお見せすることができたと思っています。

「武道館でライブをやりたい」という人がいるのとおなじように、「リアルの世界ではできない表現ができるバーチャル空間でライブをやりたい」という人が増えてくると面白いですね。

KAZOE:僕がXRライブに可能性を感じているのは、アーカイブではなく再現できるという点です。例えば、YouTubeでライブをやった時にチャットが流れてくるとそこにファンの熱気を感じますが、それがたとえ過去のものだったとしても、自分たちがそこに新たにコメントを打ち込む時は、あまり「過去のライブに参加している」という印象はないと思います。

今回作ったものをまた別の形で提供することは、プラットフォーム側の開拓次第だと捉えています。

林:今回の映像は3Dキャプチャーしてアーカイブしているので、今後、技術が上がればまた別のバージョンとしてもコンテンツ化できます。それは、3Dでデータ化できるところの良さのひとつですね。

齋藤:ReVers3:xに関しては、現状のアウトプットは2Dに限られます。ただ、逆に言えばもっといろいろできるということでもあるので、今後はできることの幅も広がっていくはずです。ソニーだと、例えばPlayStationやアニプレックスもありますし、今後の可能性としては多角的な展開などもいろいろと考えられると思います。

技術ももちろん大事ですが、最終的には視聴者が見た時に、そこから何を持ち帰るかが一番大事だと考えています。ReVers3:xに関しても、まずそこを制作チームで話し合ったうえで次のアイデアが浮かんでくると思うので、基本的には今回作ったワールドがベースになるとは思いますが、技術開発の状況次第で今後まったく違ったものになっていく可能性もありますね。

(※2022年5月29日(日)21:00「ReVers3:x vol.2」配信! 詳細は記事下部へ)

──XRが普及することでクリエイターにはどのような影響があると思いますか?

ayafuji:VRChatでは実際の自分とは違う姿のアバターを使うことができるので、本来の性別は男性であっても女性のアバターを使うなど、本当になりたい自分の姿を表現することができます。

僕の経験として、VR空間では、その空間内に設置されている鏡越しに写っている自分のアバターを見ながら、さらにそこに写っている他人のアバターとも目を合わせて話す傾向があると感じています。自分のことをそのようにして三人称的に見ることができるのは“VRだからこそ”で、そこで感じられる“フラットさ”は、そのまま自分のメンタリティにも反映されている感じがします。

KAZOE:そういう感覚を持つ人が生み出していくクリエイティビティが今後、どう世の中を変化させていくのかは楽しみですね。僕らも、そういった感覚の人たちを増やしていくためにも、新しいことをどんどんやっていきたいですね。

Volumetric Capture Studio Tokyo

林:スタジオ内には4Kカメラを設置した柱が並んでいて、直径5mの円の中が撮影できる範囲になります。弊社のスタジオの場合は円の中心に行けばいくほど、綺麗に撮影することができます。この範囲だと1〜5名ほどが歌う、踊る、演技するなどができますね。

以前は60台程度のカメラ台数でしたが、より映像を高品位にするために現在のカメラの台数は100台以上に増やしました。もちろんカメラの台数が多いほうがより高品位になるのですが、そうなると処理負荷も高くなってしまうため、現在はこの台数で品位と処理負荷のバランスを取っています。特に目線高さのカメラ数を増やして、よく使われるカメラアングルの品位を上げてます。

「ReVers3:x」第2弾

日程:2022年5月29日(日)21:00